L'essor de l'IA dans le domaine de la cybersécurité est impossible à ignorer. Les grands modèles linguistiques (LLM) tels que GPT-4 occupent désormais le devant de la scène, apparaissant dans tous les domaines, des assistants de codage aux outils de sécurité. Les tests d'intrusion, qui étaient traditionnellement un processus manuel et lent, connaissent aujourd'hui une révolution grâce à l'IA. En effet, dans une étude récente , 9 professionnels de la sécurité sur 10 ont déclaré qu'ils pensaient que l'IA finirait par remplacer les tests d'intrusion. La promesse est séduisante : imaginez la rigueur d'un pentester expérimenté combinée à la vitesse et à l'échelle d'une machine. C'est là qu'intervient le concept de « Pentest GPT », qui est en train de changer notre façon d'envisager la sécurité offensive.

Mais qu'est-ce que Pentest GPT exactement ? Et surtout, qu'est -ce que ce n'est pas? Avant de vous imaginer un script ChatGPT glorifié piratant comme par magie des systèmes, clarifions le terme et explorons comment les LLM sont intégrés dans le processus de test d'intrusion. Nous examinerons également les limites strictes des tests d'intrusion basés sur GPT, des hallucinations de l'IA aux lacunes contextuelles, et pourquoi l'expertise humaine reste essentielle. Enfin, nous verrons comment l'approche Aikido (notre plateforme de tests d'intrusion continue basée sur l'IA) relève ces défis différemment grâce à la validation humaine, à des résultats adaptés aux développeurs et à l'intégration CI/CD. Plongeons-nous dans cette nouvelle ère des tests d'intrusion assistés par l'IA avec un regard calme et pragmatique.

Que signifie (et ne signifie pas) réellement « Pentest GPT » ?

« Pentest GPT » fait référence à l'application de modèles linguistiques de type GPT aux workflows de tests d'intrusion. En termes simples, il s'agit d'utiliser un cerveau IA pour émuler certaines parties du travail d'un pentester, de la cartographie des chemins d'attaque à l'interprétation des résultats d'analyse. Cependant, cela ne se résume pas à prendre ChatGPT, à enfiler un sweat à capuche de hacker et à s'attendre à un test d'intrusion complet à partir d'une seule invite. La distinction est importante.

Les modèles généraux tels que ChatGPT sont entraînés à partir d'un large éventail de textes trouvés sur Internet et peuvent certes expliquer des concepts de sécurité ou réfléchir à des attaques, mais ils ne disposent pas, par défaut, de connaissances spécialisées en matière de sécurité offensive. Ils n'ont pas été conçus avec une compréhension approfondie des cadres d'exploitation, des bases de données CVE ou du workflow étape par étape suivi par un véritable pentester. En revanche, un véritable système Pentest GPT est généralement optimisé pour la sécurité. Il est entraîné à partir de données sélectionnées telles que des rapports sur les vulnérabilités, des manuels de la red team, des codes d'exploitation et de véritables rapports de tests d'intrusion. Cette spécialisation lui permet de « parler » le langage des outils et des techniques de piratage.

Une autre différence essentielle réside dans l'intégration. Pentest GPT n'est pas seulement un chatbot isolé, il est généralement connecté à des outils de sécurité et à des sources de données réels. Par exemple, un Pentest GPT bien conçu peut se connecter à des scanners et à des frameworks (Nmap, Burp Suite, Metasploit, etc.) afin d'interpréter leurs résultats et de recommander les étapes suivantes. Il sert de couche intelligente entre les outils, sans les remplacer complètement. Une analogie utile tirée d'un commentaire : ChatGPT peut vous donner un bon résumé de ce qu'est une injection SQL, tandis que Pentest GPT peut vous guider dans la recherche d'une injection SQL active sur un site, générer une charge utile sur mesure, valider l'exploit et même suggérer une correction par la suite. En bref, Pentest GPT est plus qu'un simple « ChatGPT + une invite = pentest ». Il s'agit d'un assistant IA spécialement conçu qui comprend le contexte du piratage et peut agir en conséquence.

Il convient également de noter ce que Pentest GPT n'est pas. Il ne s'agit pas d'un outil magique qui rend tous les autres outils obsolètes. En réalité, il s'appuie toujours sur l'arsenal habituel (scanners, scripts et exploits), mais utilise le LLM pour relier tous ces éléments entre eux. Considérez-le comme un amplificateur pour l'automatisation : il ajoute du raisonnement et du contexte aux résultats bruts fournis par les outils automatisés traditionnels. Et malgré son nom accrocheur, « PentestGPT » n'est en pratique pas un produit ou un modèle d'IA unique, mais une catégorie d'approches en pleine expansion. Les premiers prototypes tels que PentestGPT (un projet de recherche open source) et AutoPentest-GPT ont démontré la faisabilité de tests en plusieurs étapes guidés par GPT-4, et des plateformes de sécurité établies (comme Aikido) intègrent désormais un raisonnement basé sur GPT dans leurs moteurs de tests d'intrusion. Le domaine évolue rapidement, mais l'idée centrale reste la même : utiliser les LLM pour rendre pentest automatisé et plus proches de la pensée humaine.

Comment les LLM (comme GPT-4) sont utilisés dans les tests d'intrusion

Les tests d'intrusion modernes ne se limitent pas à lancer un scanner et à générer un rapport. Les testeurs expérimentés enchaînent plusieurs étapes, de la reconnaissance à l'exploitation, puis à la post-exploitation, en improvisant souvent en fonction de ce qu'ils trouvent. Les LLM s'avèrent très efficaces pour aider (voire réaliser de manière autonome) plusieurs de ces phases. Voici quelques-uns des rôles clés que joue l'IA basée sur le GPT dans le processus de test d'intrusion :

1. Raisonnement par cheminement : relier les points entre les vulnérabilités

L'une des capacités les plus puissantes d'une IA telle que GPT-4 est de planifier des attaques en plusieurs étapes, presque comme un stratège humain. Par exemple, un scanner de vulnérabilité classique pourrait vous indiquer que « le serveur X exécute un service obsolète » et, séparément, que « la base de données des utilisateurs comporte des identifiants par défaut faibles ». C'est à un pentester humain de réaliser que ces deux conclusions peuvent être combinées : se connecter à la base de données avec les identifiants par défaut et pivoter pour exploiter le serveur obsolète afin d'obtenir un accès plus approfondi. Les LLM excellent dans ce type de raisonnement. Un Pentest GPT peut automatiquement relier les points pour former un chemin d'attaque, en identifiant qu'une chaîne de problèmes de moindre gravité, lorsqu'ils sont utilisés ensemble, pourrait conduire à une compromission majeure (par exemple, les droits d'administrateur de domaine ou la prise de contrôle totale de l'application). Cette synthèse « globale » est quelque chose que les outils basés sur des règles font rarement, mais un modèle GPT peut le faire grâce à sa compréhension contextuelle. En pratique, cela signifie que les outils de test d'intrusion basés sur l'IA peuvent fournir des scénarios d'attaque, et pas seulement des conclusions isolées. Ils expliquent comment une configuration incorrecte mineure associée à une fuite de clé API pourrait dégénérer en une violation critique, donnant aux développeurs et aux équipes de sécurité une vision beaucoup plus claire des risques.

2. simulation d’attaque: élaboration et exécution d’exploits

Les LLM tels que GPT-4 sont également utilisés pour simuler les actions d'un pirate lors d'un test d'intrusion. Cela va au-delà de la simple identification d'une vulnérabilité : l'IA peut aider à exécuter les étapes d'exploitation (de manière contrôlée). Par exemple, si le système soupçonne une injection SQL dans un formulaire web, un agent IA peut générer une charge utile sur mesure pour ce formulaire spécifique et tenter de récupérer des données. S'il détecte une injection de commande, il peut tenter de créer un shell ou d'extraire des informations sensibles, comme le ferait un humain. Le modèle peut s'appuyer sur sa formation (qui comprend des milliers d'exemples d'exploitation) pour créer des chaînes de caractères ou des requêtes HTTP à la volée. Cette capacité à s'adapter et à créer des charges utiles d'attaque permet d'économiser beaucoup de script manuel. Elle permet essentiellement à l'IA d'agir en tant que développeur et opérateur d'exploits. Tout aussi important, un bon Pentest GPT validera l'effet de l'exploit, par exemple en confirmant que le SQLi a bien vidé la base de données ou que l'injection de commande permet l'exécution de code à distance, plutôt que de se fier aveuglément à sa première tentative. Dans la plateforme Aikido, par exemple, dès qu'un agent découvre un problème potentiel, il exécute automatiquement des vérifications et des charges utiles supplémentaires pour prouver que la découverte est exploitable, s'assurant ainsi que le résultat n'est pas une fausse alerte. Ce type de simulation d’attaque basée sur l'IA rapproche considérablement les tests automatisés de ce que ferait un attaquant humain créatif : essayer quelque chose, observer la réponse, ajuster sa tactique et passer à l'étape suivante.

3. Étapes en chaîne : attaques adaptatives en plusieurs étapes

Le pentesting est rarement une opération en une seule étape ; il s'agit plutôt d'une chaîne d'actions et de réactions. Les LLM sont utilisés pour orchestrer des chaînes d'attaques en plusieurs étapes de manière adaptative. Prenons un scénario : un agent IA commence par une reconnaissance, trouve des ports ouverts et des identifiants divulgués, puis utilise la logique GPT pour décider de la prochaine étape – peut-être utiliser les identifiants pour se connecter, puis lancer une exploitation d'escalade de privilèges sur le système cible, etc. Contrairement aux outils traditionnels qui suivent un script fixe, un système guidé par un LLM peut prendre des décisions à la volée. Si une voie est bloquée (par exemple, si la connexion échoue ou si un service n'est pas exploitable), il peut changer de cap de manière dynamique et essayer une autre voie, comme le ferait un être humain. Les chercheurs décrivent cette approche comme « agentique »: plusieurs agents IA gèrent différentes tâches (reconnaissance, analyse des vulnérabilités, exploitation, etc.) et se transmettent des informations, coordonnés par le raisonnement du LLM. Il en résulte un test d'intrusion automatisé qui conserve le contexte à chaque étape et apprend au fur et à mesure. Par exemple, les premières conclusions (comme une liste des rôles des utilisateurs ou un schéma API) peuvent éclairer les attaques ultérieures (comme le test du contrôle d'accès basé sur les rôles). Le raisonnement en langage naturel de GPT-4 aide ici en interprétant les données non structurées (documents, messages d'erreur) et en intégrant ces connaissances dans les exploits ultérieurs. Cette capacité d'enchaînement était traditionnellement réservée aux humains. Désormais, les agents IA peuvent gérer bon nombre de ces transitions logiques : reconnaissance → exploitation → post-exploitation → nettoyage, en enchaînant plusieurs techniques pour atteindre un objectif. Bien sûr, ce n'est pas infaillible : une logique métier complexe ou de nouveaux chemins d'attaque peuvent encore faire trébucher une IA, mais il s'agit d'un grand bond en avant en termes de capacités. C'est notamment ainsi que fonctionne le test d'intrusion IA Aikido: des dizaines ou des centaines d'agents envahissent la cible en parallèle, chacun se concentrant sur des angles différents, et le système utilise un cerveau piloté par un LLM pour coordonner leur progression à travers une chaîne d'attaque (découverte, exploitation, escalade de privilèges, etc.). Le résultat est un exercice beaucoup plus approfondi où l'IA peut faire progresser les résultats étape par étape, au lieu de s'arrêter à une longue liste de problèmes distincts.

Limites des tests d'intrusion basés sur le GPT : hallucinations, lacunes contextuelles et facteur humain

Avec tout l'engouement autour pentest IA, il est important d'aborder leurs limites et les raisons pour lesquelles les humains ne sont pas encore hors jeu. Les LLM sont puissants, mais ils présentent des faiblesses bien documentées qui ont leur importance dans le contexte de la sécurité. Voici quelques-unes des principales limites des tests d'intrusion « alimentés par GPT » et les raisons pour lesquelles les experts humains chevronnés continuent de jouer un rôle crucial :

- Hallucinations et faux positifs : les modèles GPT produisent parfois des informations qui semblent plausibles mais qui sont incorrectes, un phénomène connu sous le nom d'hallucination. Dans le cadre d'un test d'intrusion, cela peut signifier qu'une IA signale à tort une vulnérabilité qui n'existe pas ou interprète à tort un comportement bénin comme malveillant. Par exemple, un GPT pourrait inventer un « CVE-2025-9999 » fictif sur la base des modèles qu'il a observés, ou conclure à tort qu'un système est vulnérable parce qu'il s'attend à une certaine réponse. Ces faux positifs peuvent faire perdre du temps et éroder la confiance dans l'outil. Une validation rigoureuse est nécessaire pour contrer ce phénomène. (Dans le système Aikido, par exemple, aucune découverte n'est signalée tant qu'elle n'a pas été validée par un véritable exploit ou une vérification. La plateforme relance automatiquement l'attaque ou teste la charge utile pour s'assurer que le problème est reproductible.) Ce type de protection est essentiel, car un LLM, s'il n'est pas contrôlé, pourrait se convaincre de trouver des fantômes.

- Manque de contexte approfondi ou de connaissances récentes : les connaissances d'un LLM sont limitées par ses données d'entraînement. Si le modèle n'a pas été mis à jour récemment, il risque de passer à côté de vulnérabilités ou de techniques récemment divulguées. Par exemple, un exploit publié le mois dernier ne sera pas connu d'un modèle entraîné l'année dernière. De plus, les GPT ne connaissent pas intrinsèquement le contexte spécifique de votre application. Ils ne disposent pas de l'intuition ou de la familiarité qu'un testeur humain pourrait développer après avoir exploré manuellement une application pendant des jours. S'il ne dispose pas d'un contexte suffisant (comme le code source, la documentation ou les identifiants d'authentification), un agent IA peut négliger des failles logiques subtiles ou mal comprendre l'importance de certaines découvertes. Essentiellement, les GPT ont une connaissance étendue de la sécurité, mais pas une connaissance approfondie de votre environnement. Fournir à l'IA davantage de contexte (comme le code du référentiel ou les descriptions du flux utilisateur) peut atténuer ce problème, mais il existe toujours un écart entre la connaissance d'un grand nombre d'informations générales et la compréhension réelle d'un système cible sur mesure. C'est l'une des raisons pour lesquelles le jugement humain reste crucial: un testeur expérimenté peut repérer des anomalies ou des problèmes de logique métier de haut niveau qu'une IA non adaptée à l'activité pourrait ne pas saisir. (Cela dit, il est intéressant de noter que lorsque l'IA Aikidoreçoit du code et du contexte, elle a même découvert des vulnérabilités logiques complexes, telles que des contournements de flux de travail en plusieurs étapes, que les testeurs humains avaient manquées. Le contexte est roi, tant pour l'IA que pour les humains.)

- Dépendance excessive aux modèles : les IA traditionnelles utilisées pour les tests d'intrusion peuvent s'appuyer sur des modèles d'attaque et des stratégies connus. Si quelque chose sort de ces modèles, l'IA peut rencontrer des difficultés. Par exemple, un nouveau mécanisme de sécurité ou une implémentation cryptographique inhabituelle peut dérouter le modèle, alors qu'un humain pourrait l'étudier de manière créative. GPT-4 est certes capable de généraliser et même d'être créatif, mais en fin de compte, il suit les modèles statistiques de son apprentissage. Cela signifie qu'il lui est plus difficile de détecter les vulnérabilités marginales ou les failles très spécifiques à une application (par exemple, l'utilisation abusive d'une fonctionnalité d'application d'une manière dont personne n'a jamais parlé publiquement). Les humains, grâce à leur intuition et à leur capacité à gérer l'ambiguïté, restent les mieux placés pour découvrir ces problèmes étranges et ponctuels.

- Contraintes éthiques et limites de portée : considération pratique – les modèles GPT ne connaissent pas intrinsèquement les limites éthiques ou les contraintes de portée d'un test d'intrusion, sauf s'ils sont explicitement contrôlés. Un pentester humain sait qu'il ne doit pas perturber la production, éviter la destruction de données, etc. Un agent autonome peut avoir besoin de garde-fous stricts (et, en effet, les bonnes plateformes fournissent des paramètres de mode sans échec et des définitions de portée pour que les agents IA restent concentrés sur leur objectif et ne causent pas de dommages). Bien qu'il s'agisse davantage d'un problème de conception de la plateforme que d'un défaut du GPT lui-même, cela souligne la nécessité d'une supervision humaine pour garantir que l'IA fonctionne en toute sécurité et dans le respect des règles d'engagement convenues.

- Le besoin d'interprétation et d'orientation humaine : Enfin, même lorsque l'IA fait tout correctement, vous avez souvent besoin d'un humain pour interpréter les résultats en vue de décisions stratégiques. Par exemple, décider quelles vulnérabilités sont réellement importantes pour l'entreprise ou réfléchir à la manière dont un attaquant pourrait exploiter une découverte au-delà de ce qui a été fait automatiquement peut nécessiter une touche humaine. Il y a aussi l'aspect de la confiance – de nombreuses organisations souhaitent qu'un expert en sécurité humain examine un rapport de pentest généré par l'IA, à la fois pour le vérifier et pour le traduire en termes commerciaux si nécessaire. L'IA peut générer beaucoup de données ; l'expertise humaine est nécessaire pour prioriser et planifier la remédiation dans le contexte d'un programme de sécurité plus large.

En résumé, le pentest basé sur GPT est un multiplicateur de force plutôt qu'un remplacement pour les humains. Il peut gérer le gros du travail des attaques de routine, couvrir plus de terrain et le faire en continu. Mais les humains définissent toujours les objectifs, gèrent les cas inédits et fournissent un jugement critique sur les risques. Comme l'a souligné une observation, les meilleurs résultats sont obtenus lorsque GPT est associé à des outils déterministes et à une supervision humaine – l'IA assure le raisonnement et le reporting, tandis que les outils et les personnes garantissent une validation fiable. La plupart des équipes adoptant le pentest IA l'utilisent comme couche fondamentale, puis ajoutent une révision humaine pour la dernière étape. De cette façon, vous bénéficiez de l'efficacité de l'IA et de la sagesse des experts humains travaillant en tandem.

L'approche d'Aikido : pentest IA continu avec une touche humaine

Chez Aikido Security, nous avons intégré l'IA dans le pentest via notre plateforme (appelée Aikido “Attack”), mais nous l'avons fait en portant une attention particulière aux limites mentionnées ci-dessus. L'objectif est de tirer parti des LLM pour ce qu'ils font le mieux – vitesse, évolutivité et raisonnement – tout en atténuant leurs faiblesses. Voici comment les pentests basés sur l'IA d'Aikido diffèrent d'un script “Pentest GPT” de base ou des outils automatisés traditionnels :

- Tests continus et à la demande (intégration CI/CD) : Aikido vous permet d'exécuter des pentests chaque fois que vous en avez besoin – même à chaque modification de code. Au lieu d'un pentest annuel « big-bang », vous pouvez intégrer les tests de sécurité basés sur l'IA dans votre pipeline CI/CD ou vos déploiements de staging. Cela signifie que les nouvelles fonctionnalités ou corrections sont testées immédiatement, et la sécurité devient un processus continu plutôt qu'un événement ponctuel. Notre plateforme est conçue pour les workflows des développeurs, vous pouvez donc déclencher un pentest sur une pull request ou planifier des exécutions nocturnes. Au moment où votre application passe en production, elle a déjà subi une série de tests alimentée par l'IA. Cette approche continue comble le fossé de vitesse où le code change souvent quotidiennement, mais les pentests manuels sont rares. Avec les agents IA, les tests suivent le rythme du développement.

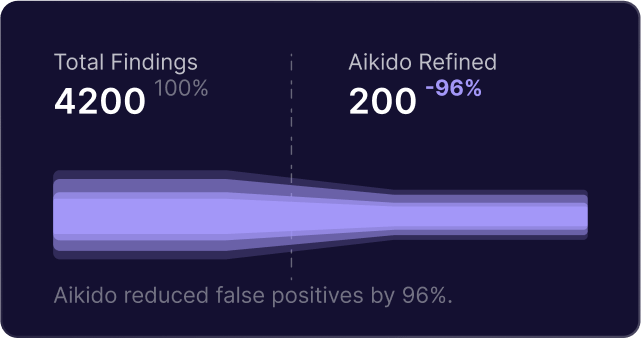

- Résultats validés et sans bruit : Nous reconnaissons que la sortie d'une IA nécessite une vérification. Le moteur de pentest d'Aikido dispose d'une validation intégrée à chaque étape. Lorsque l'IA suspecte une vulnérabilité, elle ne la signale pas immédiatement – elle lance un agent de validation secondaire pour reproduire l'exploit de manière propre et confirmer l'impact. Seuls les problèmes avérés et exploitables figurent dans le rapport final. Cette conception signifie que vous obtenez pratiquement zéro faux positifs (si un problème n'est pas confirmé, il n'est pas signalé) et notre système se prémunit activement contre les hallucinations de l'IA concernant les vulnérabilités. Le résultat est que les développeurs ne sont pas bombardés d'alertes de « problème possible » ou de découvertes spéculatives – ils voient des failles de sécurité réelles et confirmées avec des preuves. Cette approche marie la créativité de GPT avec la prudence d'un testeur humain : chaque découverte est essentiellement vérifiée deux fois, vous pouvez donc faire confiance à la sortie.

- Visibilité complète et résultats adaptés aux développeurs : Le pentest IA d'Aikido ne fonctionne pas comme une boîte noire. Nous vous offrons une visibilité complète sur ce que font les agents IA – chaque requête, charge utile et tentative d'attaque peut être observée en direct dans notre tableau de bord. C'est crucial pour la confiance et l'apprentissage des développeurs. Vous pouvez voir pourquoi une vulnérabilité a été signalée et comment elle a été exploitée, jusqu'aux traces de requêtes/réponses et même aux captures d'écran de l'attaque en cours. Les résultats finaux sont présentés dans un rapport prêt pour l'audit qui inclut tous les détails techniques (endpoints affectés, étapes de reproduction, horodatages) ainsi que des descriptions des risques en langage clair et des conseils de remédiation. Nous visons à rendre la sortie adaptée aux développeurs : au lieu d'une vague « Vulnérabilité dans le module X », vous obtenez une explication claire du problème, comment le reproduire et comment le corriger. Nous allons même plus loin – notre plateforme inclut une fonctionnalité AutoFix qui peut prendre certaines découvertes (comme une injection SQL ou une injection de commande détectée) et générer automatiquement une pull request Git avec les modifications de code proposées pour résoudre le problème. Les développeurs peuvent examiner cette correction générée par l'IA, la merge, puis demander à Aikido de retester immédiatement l'application pour vérifier que la vulnérabilité est résolue. Cette boucle détection→correction→retest étroite signifie une remédiation plus rapide et moins d'allers-retours. Tout cela est fait de manière à ce que les développeurs puissent facilement digérer l'information, en évitant le jargon de sécurité ou une sortie brute de scanner interminable. Il s'agit de rendre les résultats du pentest exploitables.

- L'expertise humaine dans la boucle : Bien que nos agents de pentest opèrent de manière autonome, nous n'avons pas supprimé l'élément humain – nous l'avons augmenté. Premièrement, le système lui-même a été entraîné et affiné avec l'apport de pentesteurs seniors, encodant leurs workflows et leurs connaissances. Mais au-delà de cela, nous encourageons et soutenons la validation humaine là où elle compte. De nombreux clients d'Aikido utilisent les résultats de l'IA comme base de référence, puis demandent à leur équipe de sécurité ou à un analyste Aikido d'effectuer une révision rapide, en particulier pour les applications critiques. Notre expérience a montré que l'IA détectera la grande majorité des problèmes techniques (et même de nombreuses failles logiques complexes) par elle-même. Pourtant, nous savons que la sécurité est finalement une question de défense en profondeur – une vérification humaine peut donc ajouter de l'assurance, et nous facilitons la collaboration autour des résultats de l'IA. De plus, si l'exécution de l'IA ne trouve rien de critique (ce qui est une excellente nouvelle), les organisations ont l'esprit tranquille grâce à notre politique selon laquelle “Zéro découverte = Zéro coût” pour certains engagements. Cette garantie reflète notre confiance dans la rigueur de l'IA, mais assure également que si un humain trouve plus tard quelque chose que l'IA a manqué, vous n'avez pas payé pour un test incomplet. En bref, l'approche d'Aikido combine l'automatisation de l'IA avec des options de supervision humaine pour offrir le meilleur des deux mondes.

- Sécurité et contrôle du périmètre : Aikido Attack a été conçu en tenant compte des besoins des entreprises, nous avons donc ajouté des contrôles robustes pour maintenir l'IA sur la bonne voie. Avant l'exécution d'un pentest IA, vous définissez le périmètre exact : quels domaines ou adresses IP sont des cibles autorisées, lesquels sont hors limites (mais peuvent être consultés en lecture seule), les détails d'authentification, et même les fenêtres horaires pour les tests. La plateforme applique ces règles avec un proxy intégré et des vérifications préliminaires – si quelque chose est mal configuré ou hors périmètre, le test ne se poursuivra pas, évitant ainsi les accidents. Il existe également un « bouton d'urgence » instantané pour arrêter immédiatement les tests si nécessaire. Ces mesures garantissent qu'un test autonome ne dévie jamais et n'effectue que des actions sûres et convenues, tout comme le ferait un pentesteur humain diligent. Pour en savoir plus sur la façon dont nous protégeons votre environnement, consultez l'architecture de sécurité d'Aikido.

Dans l'ensemble, la solution de pentest basée sur l'IA d'Aikido répond à la promesse de Pentest GPT tout en résolvant ses pièges. Vous obtenez un pentest continu et intelligent qui peut pivoter et raisonner à travers les attaques comme un humain, sans l'attente ou le coût typiques des tests manuels. En même temps, vous n'obtenez pas le bruit habituel de l'automatisation – chaque découverte est réelle et est accompagnée de contexte. Et vous avez toujours la possibilité (et nous l'encourageons) d'impliquer des ingénieurs de sécurité pour la validation finale ou pour gérer les cas limites, garantissant que rien ne passe à travers les mailles du filet. C'est une application équilibrée et pragmatique de l'IA : utilisez la machine pour ce qu'elle fait de mieux (vitesse, évolutivité, reconnaissance de formes) et laissez les humains faire ce qu'ils font de mieux (pensée créative et jugement global). Le résultat final est un processus de pentest plus rapide et plus fréquent, mais aussi approfondi et fiable.

De la mode à la réalité : essayez le pentest basé sur l'IA par vous-même

Explorez les ressources et outils externes référencés dans cette approche :

- Nmap – Mappeur de réseau open source utilisé pour la reconnaissance.

- Burp Suite – Scanner de vulnérabilités web et proxy utilisé dans de nombreux pentests basés sur l'IA.

- Metasploit – Framework de pentest pour le développement et l'exécution d'exploits.

- Base de données CVE (NVD) – La base de données nationale des vulnérabilités pour le suivi des failles de sécurité.

- PentestGPT GitHub – Projet de recherche open source Pentest GPT.

- Projet AutoPentest-GPT – Framework de pentest automatisé basé sur la technologie GPT.

Pour découvrir comment vous pouvez apporter un pentest continu et intelligent à votre organisation, démarrez avec Aikido en 5 minutes ou lisez les témoignages de clients sur les organisations qui réduisent déjà les risques grâce à l'IA.

Pour plus de contenu éducatif sur le développement sécurisé, le DevSecOps et l'IA dans la sécurité, parcourez le Blog Aikido.

L'IA ne remplacera pas les experts en sécurité humains – mais elle rendra leur travail plus efficace et aidera les organisations à sécuriser les logiciels à un rythme qui correspond au développement moderne. Les LLM prouvent qu'ils peuvent prendre en charge une grande partie du gros du travail des tests d'intrusion, de la recherche de faiblesses dans une application à l'écriture d'exploits et à la compilation de rapports. Comme nous l'avons vu, le terme Pentest GPT désigne cette nouvelle génération d'outils qui fusionnent le raisonnement de l'IA avec le savoir-faire en matière de hacking. Ce n'est pas seulement du battage médiatique ; cela redéfinit déjà la manière dont les pentests sont effectués, transformant une épreuve annuelle en une pratique continue et adaptée aux développeurs.

Si vous êtes curieux de voir cela en action, pourquoi ne pas essayer le pentest IA d'Aikido ? Nous offrons un moyen d'exécuter un pentest gratuit et en libre-service sur votre propre application pour découvrir comment les agents autonomes travaillent aux côtés de votre cycle de développement. En quelques minutes, vous pouvez configurer un test et regarder les agents IA sonder systématiquement votre application – avec une transparence et un contrôle total. Vous obtiendrez un rapport détaillé en quelques heures (pas en semaines), et vous pourrez même l'intégrer à votre pipeline CI afin que chaque nouvelle version soit testée automatiquement. C'est l'occasion de voir comment les concepts de Pentest GPT – raisonnement de chemin, exploitation intelligente, validation des résultats – se concrétisent dans un produit réel.

Conseil de pro : Vous pouvez démarrer un pentest basé sur l'IA sur Aikido gratuitement (aucune carte de crédit requise) ou [en savoir plus sur notre site web] sur son fonctionnement. Nous sommes convaincus qu'une fois que vous verrez l'IA trouver et corriger les vulnérabilités à la vitesse de la machine, vous conviendrez que c'est une manière plus sereine et plus intelligente de sécuriser vos logiciels.

En résumé, l'IA est là pour rester dans la cybersécurité. La clé est de l'utiliser judicieusement. Pentest GPT, en tant que concept, vise à augmenter l'expertise humaine avec les incroyables capacités de l'IA – et non à remplacer cette expertise. La mission d'Aikido est de fournir des pentests continus basés sur l'IA avec validation humaine intégrée, afin que vous puissiez détecter les problèmes tôt, fréquemment et en toute confiance. À mesure que l'industrie évolue, ceux qui combinent l'efficacité de l'IA avec l'ingéniosité de l'intelligence humaine seront les mieux placés pour sécuriser leurs systèmes contre un paysage de menaces en constante évolution. L'avenir du pentest s'écrit maintenant – et il est écrit en partie par GPT-4.

(Intéressé par la prochaine étape ? Vous pouvez démarrer un pentest IA en 5 minutes sur la plateforme d'Aikido ou planifier une démo pour voir comment il s'intègre à votre workflow DevSecOps. Les tests de sécurité n'ont pas à être lents ou cloisonnés – avec les bons outils d'IA, ils deviennent une partie continue du développement, permettant à votre équipe de créer et de livrer des logiciels en toute sérénité.)

Sécurisez votre logiciel dès maintenant.