.png)

État de l'IA en Sécurité et Développement

Notre nouveau rapport recueille les témoignages de 450 leaders de la sécurité (CISO ou équivalent), développeurs et ingénieurs AppSec à travers l'Europe et les États-Unis. Ensemble, ils révèlent comment l'IA dans la cybersécurité et le développement logiciel perturbe déjà les choses, comment la prolifération des outils aggrave la sécurité, et comment l'expérience développeur est directement liée aux taux d'incidents. C'est là que vitesse et sécurité s'entrechoquent en 2026.

Principales conclusions

.jpg)

Adoption de l'IA

1 sur 5 a subi un incident grave lié au code IA

.png)

« Alors que les organisations luttent pour tirer parti des avantages de l'IA, il y a souvent une bataille cachée associée qui se déroule, celle de protéger leur organisation contre l'augmentation des cyber-risques que l'IA présente. Le rôle du CISO est de s'assurer que la posture de sécurité évolue aussi rapidement que la technologie. »

53% blâment l'équipe de sécurité pour les incidents liés au code IA

« Il y a clairement un manque de clarté parmi les répondants quant à la répartition des responsabilités pour une bonne gestion des risques. »

.png)

Expérience Développeur

15 %

du temps des ingénieurs est perdu à trier les alertes

Cela représente 20 millions de dollars par an pour une organisation de 1000 développeurs.

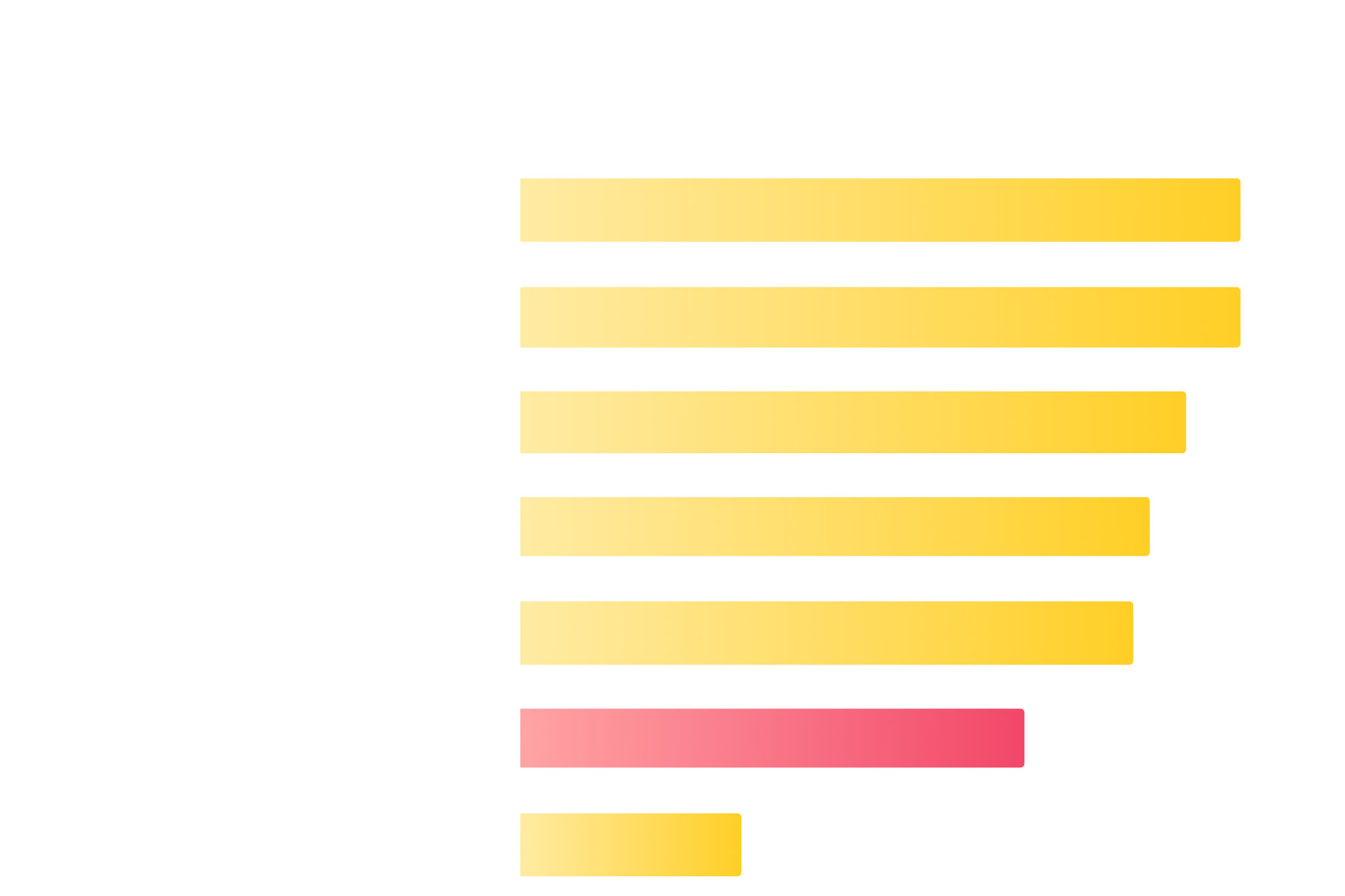

Coût annuel estimé du temps des développeurs consacré au tri

.png)

2/3 des répondants contournent la sécurité, ignorent les résultats ou retardent les correctifs

.png)

« Lorsque les outils de sécurité submergent les développeurs de bruit, ils se tournent vers des solutions de contournement risquées. Nous visons à rétablir l'équilibre en éliminant les faux positifs, en renforçant les garde-fous et en améliorant l'expérience développeur, afin que les équipes puissent se concentrer sur ce qui compte vraiment. »

Les outils conçus pour les équipes de développement et de sécurité ont enregistré beaucoup moins d'incidents

Les équipes utilisant des outils conçus à la fois pour les développeurs et les équipes de sécurité étaient plus de deux fois plus susceptibles de signaler zéro incident, comparé à celles utilisant des outils conçus pour un seul groupe.

.png)

« Donner aux développeurs le bon outil de sécurité, qui fonctionne avec les outils et les workflows existants, permet aux équipes de mettre en œuvre les meilleures pratiques de sécurité et d'améliorer leur posture. »

.jpg)

La réalité de la sécurité

« Il est un peu ironique que l'industrie parle tant de remplacer les humains par l'IA, mais dans la sécurité, nous nous inquiétons bien plus de ne pas avoir suffisamment de personnel de sécurité. »

.jpg)

Les équipes utilisant des outils AppSec et CloudSec distincts ont 50 % plus de chances de faire face à des incidents

.png)

"Il est clair que nous devons combiner nos programmes AppSec et Cloud Security en une seule équipe de sécurité produit. Pour les entreprises où l'infrastructure est définie comme du code, la sécurité du cloud est fondamentalement la sécurité du code, et cela conduit à de meilleurs résultats."

L'avenir de l'IA

96 % pensent que l'IA écrira du code sécurisé et fiable

9 organisations sur 10 s'attendent à ce que l'IA prenne en charge les tests d'intrusion, avec un délai moyen de 5,5 ans.

.png)

.png)

.svg)