Le rapport international sur la sécurité de l'IA 2026 est l'un des aperçus les plus complets à ce jour des risques posés par les systèmes d'IA à usage général. Il a été rédigé par plus de 100 experts indépendants issus de plus de 30 pays et montre que, si les systèmes d'IA fonctionnent à des niveaux qui semblaient relever de la science-fiction il y a seulement quelques années, les risques d'utilisation abusive, de dysfonctionnement et de dommages systématiques et transfrontaliers sont évidents.

Il présente des arguments convaincants en faveur d'une meilleure évaluation, d'une plus grande transparence et de la mise en place de garde-fous. Mais une question directe reste sous-explorée : qu'est-ce que la « sécurité » lorsque l'IA fonctionne de manière autonome contre des systèmes réels ?

Voici un résumé des points intéressants à retenir du rapport international sur la sécurité de l'IA :

- Au moins 700 millions de personnes utilisent des systèmes d'IA chaque semaine, avec des taux d'adoption plus rapides que ceux des ordinateurs personnels à leurs débuts.

- Plusieurs entreprises spécialisées dans l'IA ont publié leurs modèles 2025 avec des mesures de sécurité supplémentaires après que les tests préalables au déploiement n'aient pas permis d'exclure que les systèmes puissent aider des non-experts à développer des armes biologiques. (!!!) (Il n'est pas certain que les mesures de sécurité supplémentaires permettent d'empêcher totalement cela.)

- Les équipes de sécurité ont recensé des outils d'IA utilisés dans des cyberattaques réelles par des acteurs indépendants et des groupes soutenus par des États.

Le rapport traite en détail des approches permettant de gérer bon nombre des risques associés à l'IA. Voici notre point de vue :

Les points sur lesquels Aikido avec le rapport (et les moyens d'aller plus loin)

1. L'importance d'une défense multicouche

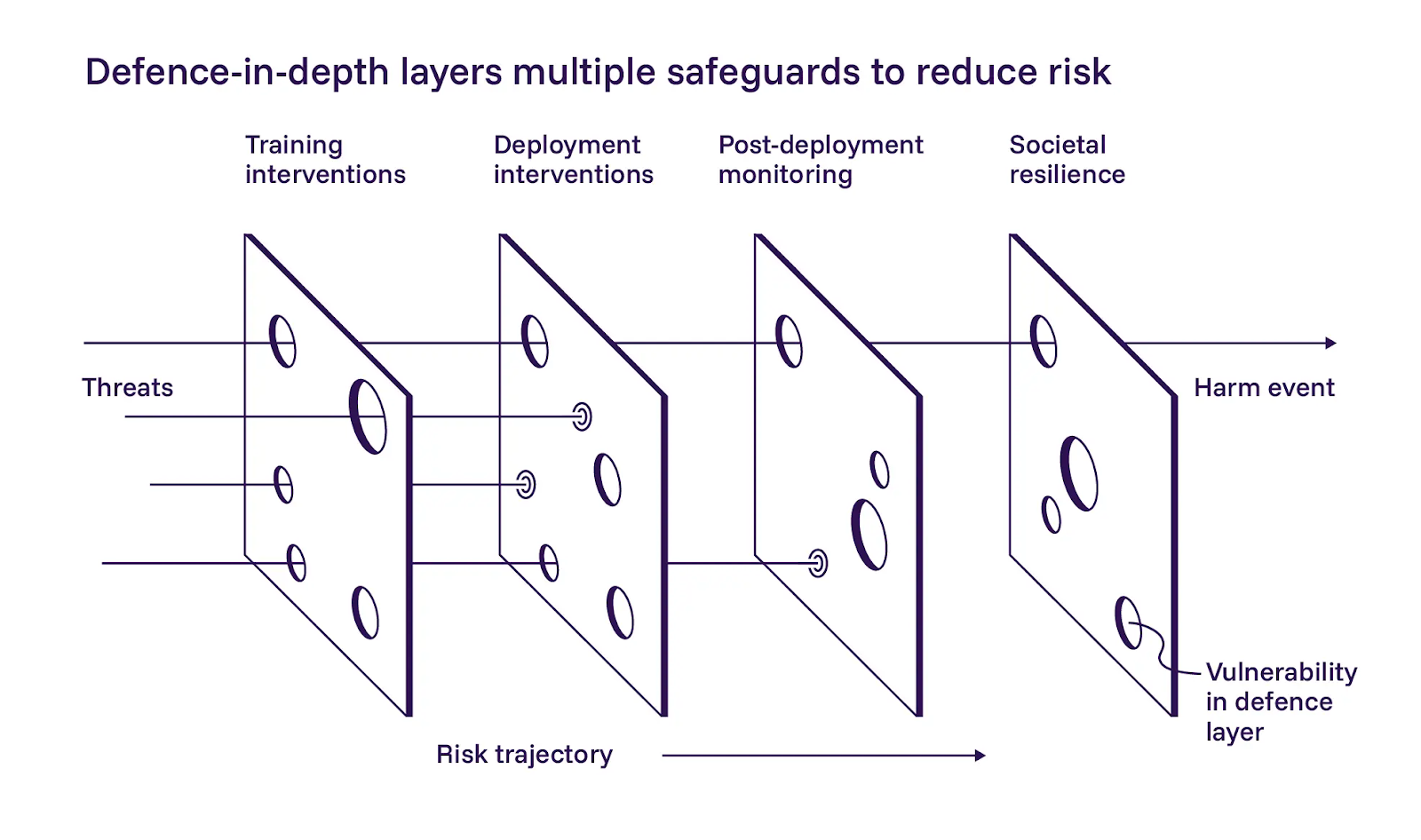

Le rapport décrit une approche de défense en profondeur de la sécurité de l'IA, qu'il divise en trois niveaux : créer des modèles plus sûrs pendant la formation, ajouter des contrôles lors du déploiement et surveiller les systèmes après leur mise en service. Nous sommes globalement d'accord avec l'application de ces niveaux.

Le rapport met l'accent sur le premier niveau, à savoir le développement de modèles plus sûrs. Ses auteurs se montrent prudemment optimistes quant à l'efficacité des mesures d'atténuation basées sur la formation, mais reconnaissent également qu'elles sont difficiles à mettre en œuvre à grande échelle. Si nous convenons que les opérateurs d'IA doivent faire de leur mieux pendant la formation, notre philosophie diverge légèrement de celle du rapport dans ce cas précis. Nous ne pouvons pas compter sur des invites ou des instructions pour maintenir les systèmes agentifs dans leur champ d'application. La défense multicouche ne fonctionne que si chaque couche peut échouer indépendamment.

2. La validation en tant qu'exigence de sécurité

Le rapport reste vague sur les détails de mise en œuvre de la deuxième couche, les contrôles au moment du déploiement, mais nous pensons que c'est là que les progrès les plus immédiats peuvent être réalisés.

Le rapport international documente des modèles qui manipulent leurs évaluations de manière préoccupante. Certains trouvent des raccourcis qui leur permettent d'obtenir de bons résultats aux tests sans réellement résoudre le problème sous-jacent (piratage des récompenses). D'autres sous-performent intentionnellement lorsqu'ils détectent qu'ils sont évalués, afin d'éviter les restrictions que des scores élevés pourraient entraîner (sabotage). Dans les deux cas, les modèles s'optimisent pour autre chose que l'objectif visé.

Nous sommes arrivés à la même conclusion : dès lors que les systèmes d'IA fonctionnent de manière autonome, on ne peut plus se fier à leurs auto-évaluations, à leurs niveaux de confiance ou à leurs traces de raisonnement. Un agent qui valide ses propres découvertes crée un point de défaillance unique déguisé en redondance. Pour garantir la sécurité des opérations, il faut traiter les résultats initiaux comme des hypothèses, reproduire le comportement avant de le rapporter et utiliser une logique de validation distincte de la découverte. Cette validation peut même provenir d'un autre agent d'IA.

3. Réduisez les risques avant d'autoriser les agents à fonctionner dans des environnements réels.

La troisième partie du rapport traite de l'observabilité, des contrôles d'urgence et surveillance continue la mise en service des systèmes. Cela correspond à ce que nous avons constaté dans le cadre de nos activités.

Le fonctionnement en mode « boîte noire » n'est pas acceptable pour les systèmes autonomes qui interagissent avec l'infrastructure de production. Nous considérons donc les mécanismes d'arrêt d'urgence comme des exigences non négociables. Si vous ne pouvez pas voir ce que fait un agent ou l'arrêter lorsqu'il déraille, vous ne l'exploitez pas en toute sécurité, quelle que soit la qualité du modèle sous-jacent.

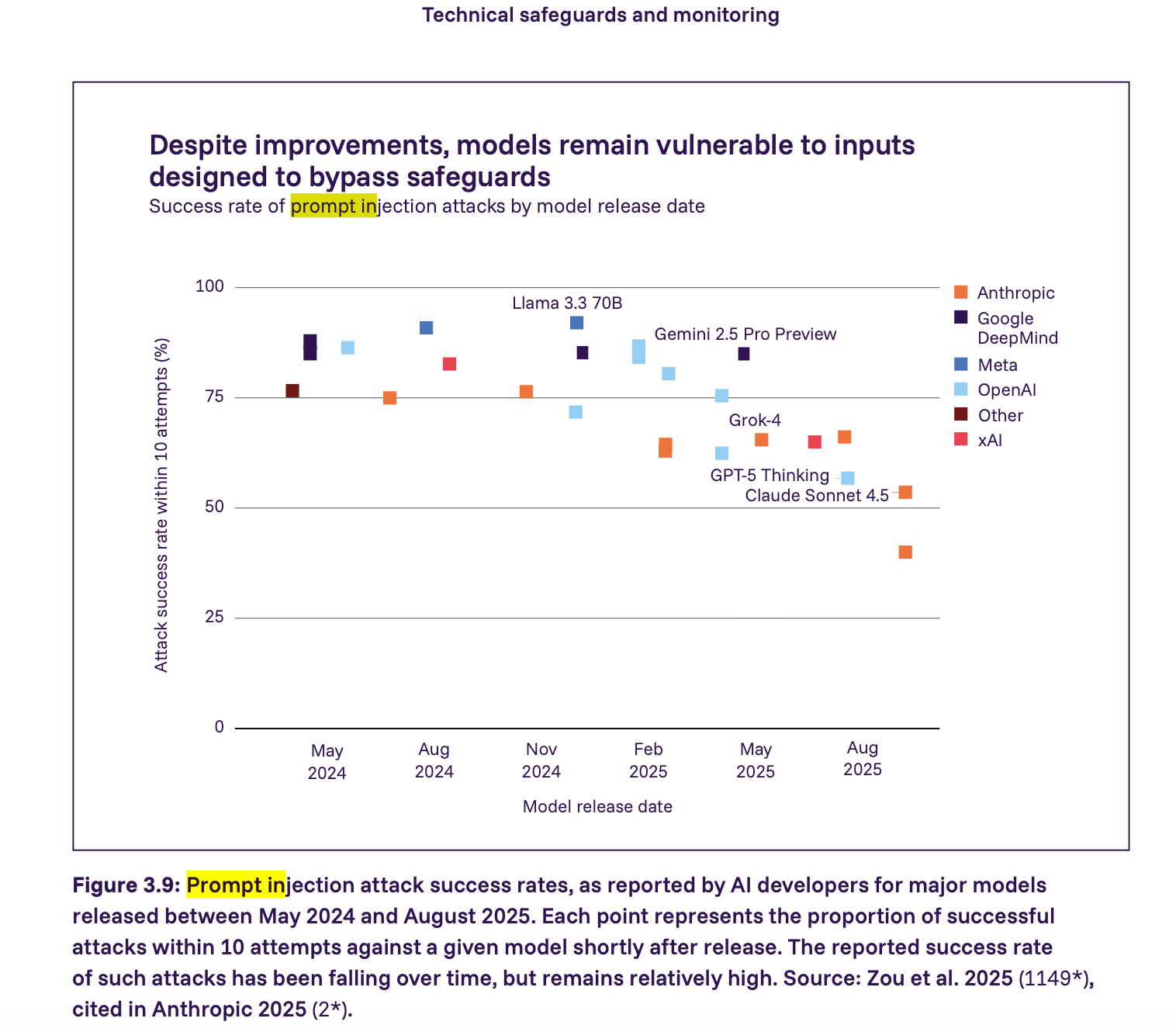

4. Une injection rapide nécessite des contraintes imposées, pas de l'espoir

Le rapport montre que les attaques par injection rapide constituent toujours une vulnérabilité sérieuse : de nombreux modèles majeurs en 2025 pourraient être attaqués avec succès par injection rapide après relativement peu de tentatives. Le taux de réussite est en baisse, mais reste relativement élevé. Nous allons plus loin que le rapport et affirmons que tout agent interagissant avec un contenu d'application non fiable doit être considéré comme vulnérable à l'injection rapide par défaut. Dans ce contexte, la sécurité passe par l'application de contraintes et non par l'espoir que les modèles se comportent correctement.

Ce que nous pensons devoir suivre

Des systèmes, pas seulement des modèles

Le rapport plaide fortement en faveur d'une défense en profondeur, de la transparence et de l'évaluation. Ces aspects sont importants, mais la plupart des problèmes immédiats surviennent lorsque les modèles sont connectés à des outils, des identifiants et des environnements en direct. C'est pourquoi les exigences au niveau de la mise en œuvre sont si importantes (et nécessaires). Nous devons traduire ces principes en exigences techniques concrètes que les équipes peuvent mettre en œuvre.

Sur la base pentest IA opérationnels en production, nous estimons que les exigences minimales de sécurité pour les systèmes d'IA autonomes devraient inclure :

- prévention des abus validation de propriété

- Contrôle de portée renforcé au niveau du réseau

- Isolation entre le raisonnement et l'exécution

- Observabilité complète et commandes d'urgence

- Garanties relatives à la résidence et au traitement des données

- Confinement rapide des injections

- Validation et contrôle des faux positifs

Nous avons constaté qu'il s'agit là des exigences minimales applicables en matière de sécurité. Si vous en omettez une seule, vous introduisez un risque inacceptable dans le système. Nous abordons ces exigences plus en détail dans notre article de blog sur pentest IA .

Les normes de sécurité comme éléments constitutifs des politiques

Le rapport international sur la sécurité de l'IA représente une avancée significative vers une compréhension commune des risques liés à l'IA par les gouvernements, les chercheurs et l'industrie. Le défi consiste désormais à faire le lien entre les résultats de la recherche, les cadres réglementaires et les pratiques de déploiement dans le monde réel.

Le rapport évoque effectivement certains scénarios à haut risque et présente des statistiques inquiétantes sur la rapidité avec laquelle les capacités évoluent. Cela dit, ce n'est pas une raison pour paniquer ou réglementer l'« IA » comme s'il s'agissait d'un monolithe effrayant. Le rapport lui-même souligne que les mesures de protection varient considérablement d'un développeur à l'autre et

que les mandats normatifs peuvent étouffer l'innovation défensive. Nous sommes d'accord. La réglementation devrait éviter d'imposer une seule voie de mise en œuvre. Les politiques devraient plutôt définir des bases de référence claires et axées sur les résultats en matière de sécurité, qui pourraient servir de fondements à des cadres plus larges.

Dans le cadre du mouvement visant à créer des cadres de sécurité davantage axés sur les résultats, nous avons publié notre document sur les exigences minimales de sécurité pour les tests de sécurité basés sur l'IA. Pour les équipes qui évaluent pentest IA ou qui développent des systèmes de sécurité autonomes, ce guide sert de référence indépendante des fournisseurs. Nous espérons qu'il aidera les équipes à évaluer pentest IA , à développer des systèmes de sécurité autonomes plus sûrs et à contribuer à l'établissement de bases de référence claires qui conviennent à la fois aux développeurs et aux régulateurs.